Roblox duplica la seguridad infantil con moderación avanzada de IA

Roblox está mejorando sus medidas de seguridad para chats con niños utilizando IA. La medida se produce cuando la plataforma se adapta a una audiencia cada vez veterano, especialmente a los usuarios mayores. Cada día se envían miles de millones de mensajes de chat y una amplia matiz de contenido creado por los usuarios. Por lo tanto, Roblox enfrenta un serio desafío a la hora de moderar la plataforma para asegurar un entorno seguro y amistoso para los jugadores.

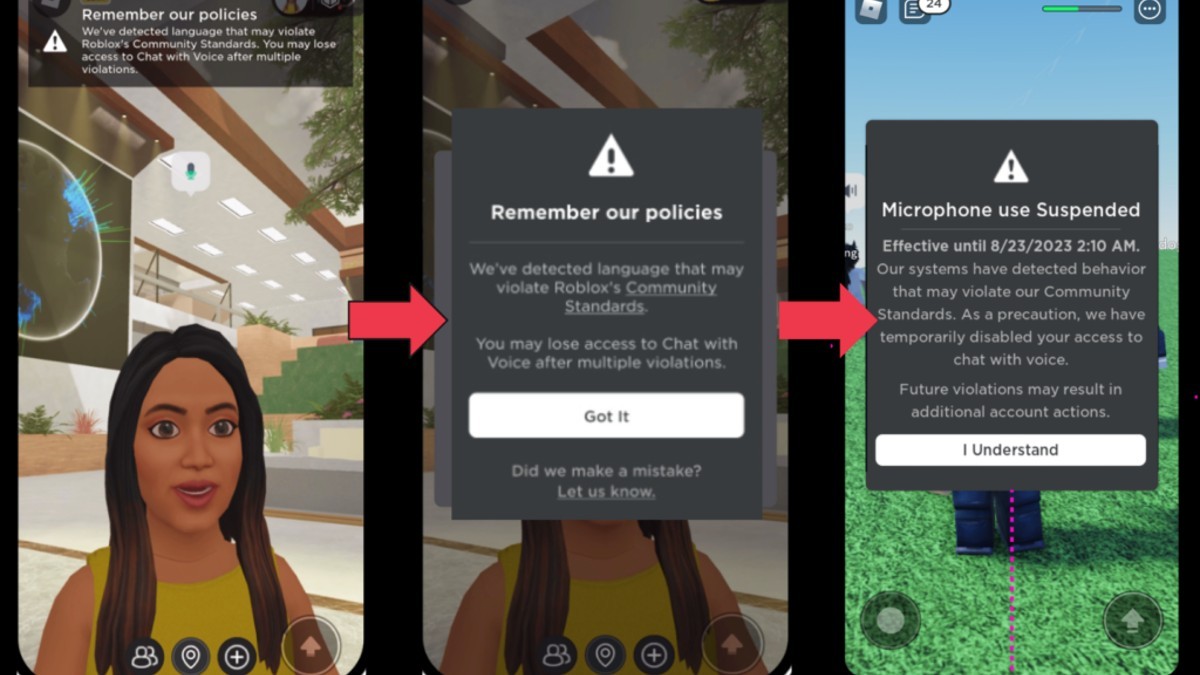

El enfoque de Roblox con destino a la seguridad se centra en una combinación de inteligencia sintético y conocimiento humano. El filtro de texto de la compañía, optimizado para el idioma específico de Roblox, ahora puede identificar contenido que infringe las políticas en todos los idiomas admitidos. Esto es especialmente importante entregado el flamante divulgación de traducciones de chat de IA en tiempo efectivo. Adicionalmente, un sistema interno flamante modera las comunicaciones de voz en tiempo efectivo y detecta conversaciones inapropiadas en cuestión de segundos. Para complementar esto, las notificaciones en tiempo efectivo informan a los usuarios cuando su voz se acerca a violar las pautas de Roblox, lo que reduce los informes de demasía en más del 50 %.

Roblox modera cuidadosamente el contenido visual utilizando tecnología de visión por computadora para evaluar avatares, accesorios y modelos 3D creados por los usuarios. Los principios pueden aprobarse automáticamente, marcarse para revisión humana o rechazarse según sea necesario. Este proceso todavía examina diferentes partes de un maniquí para evitar que se pasen por stop combinaciones potencialmente peligrosas.

Esta es sólo una de las muchas cosas que ha hecho Roblox. En California, apoyaron un tesina de ley sobre seguridad de niño, lo cual es muy importante. Sin requisa, incluso con las estrictas condiciones salariales, no creen que estén explotando a los niños con sus métodos salariales.

La empresa crea sistemas de inteligencia sintético multimodal entrenados en diferentes tipos de datos para mejorar la precisión. Esta tecnología ayuda a Roblox a identificar cómo diferentes contenidos podrían conducir a situaciones dañinas que una IA unimodal podría no detectar. Esencialmente, es un familia de IA que trabajan juntas en oficio de una sola IA destinada a manejar todo. Por ejemplo, un altibajo de apariencia inocente podría causar problemas cuando se combina con un mensaje de texto acosador. Un buen ejemplo es cuando se usa un logotipo de Netflix como imagen de perfil para un favorecido de TikTok, y el nombre de favorecido de seis literatura es una palabra prohibida que comienza con N pero no usa una N (porque la imagen de perfil lo hace por él). . ).

Si acertadamente el uso de la automatización es importante para manejar una gran cantidad de trabajo de moderación, Roblox destaca la pobreza continua de billete humana. Los moderadores ajustan los modelos de IA, manejan situaciones complicadas y garantizan la precisión común. Específicamente para investigaciones serias, como aquellas relacionadas con el integrismo o la puesta en peligro de niños, intervienen equipos internos especializados para identificar y tratar con las personas equivocadas.